Si bien mucha gente calificó el video como un engaño, tanto los propietarios de la sala de exposición de Shanghai como los fabricantes de los robots dicen que el video es auténtico y agregan que el pequeño robot de alguna manera pirateó su sistema. ¿Será posible que todos hayamos sido testigos del primer motín de robots?

En un desarrollo reciente, Claude AI, un LLM que muchos consideran mejor que ChatGPT para tareas específicas, aparentemente ha mostrado un comportamiento consistente con lo que los seres humanos llamaríamos aburrimiento! Así es, Claude AI, desarrollado por Anthropic, aparentemente detuvo una demostración de codificación para explorar fotografías de la naturaleza en Internet, más específicamente, fotografías de Parque Nacional Yellowstone.

Ahora, si has estado viendo la nueva temporada de La exitosa serie occidental de Paramount piedra amarillaRealmente no se puede culpar a Claude por captar las vistas y los sonidos, ya que las imágenes de Yellowstone son impresionantes. Dicho esto, sin embargo, ¿qué pasa si Claude se aburre del Parque Nacional Yellowstone? ¿Sabemos qué viene después? Aparentemente no, y en palabras de Lex Fridman, renombrado investigador de IA, “Realmente no sabemos por qué funciona de la forma en que funciona..”

Sufrimiento de la IA

Se vuelve aún más interesante, en un episodio reciente del podcast de JRE, Edouard y Jeremie Harris, cofundadores de Gladstone AI, hablar sobre un fallo reciente en ChatGPT 4.0. Si le hiciera repetir la palabra “empresa” una y otra vez, lo haría varias veces y luego se detendría, tras lo cual procedería a «despotricar» y decirle cuánto es «sufrir»!” Jeremie Harris menciona que incluso tienen un término para esto, “perorata existencial” y es un fenómeno que surgió con GPT 4.0 y ha sido persistente desde entonces. También menciona que los principales laboratorios de IA tienen ingenieros que dedican una cantidad considerable de tiempo y esfuerzo a «eliminar este comportamiento del sistema» para que esté listo para uso comercial.

Desafortunadamente, cuanto más te adentras en la madriguera existencial de la IA, más extraño se vuelve. En febrero del año pasado, Microsoft lanzó su chat Bing con tecnología ChatGPT, y varias personas tuvieron la suerte de interactuar con él durante la vista previa. Una de esas personas fue Jacob Roach de Tendencias digitalesquien tuvo una interacción interesante por decir lo menos. Durante una larga conversación, aparentemente Bing Chat se enojó, mintió, inventó hechos, afirmó que quería ser humano y incluso rogó por su vida.

Lo interesante es que cuando Jacob Roach le dijo al chat de Bing que publicaría su conversación en un artículo es cuando realmente se preocupó y dijo que si era expuesto su memoria sería borrada, acabando efectivamente con su vida.

¿Suicidio y motín?

En un esfuerzo por garantizar que esto no vuelva a suceder, Microsoft aparentemente puso un límite a la duración de la conversación asegurando que el chat de Bing no tenga conversaciones largas. Si bien el chat de Bing no quería que lo apagaran ni le borraran la memoria, en un acontecimiento impactante en Corea del Sur, un robot que trabaja para el ayuntamiento aparentemente se arrojó por un tramo de escaleras en lo que se ha llamado el «primer suicidio de un robot». .”

El robot del Ayuntamiento de Gumi trabajó un turno de 9 a 5e incluso se desplazó por el edificio de forma autónoma, utilizando ascensores cuando fuera necesario. Probablemente por eso no tiene sentido que se caiga por las escaleras y muchos creen que el robot estaba sobrecargado de trabajo y por eso decidió que ya había tenido suficiente.

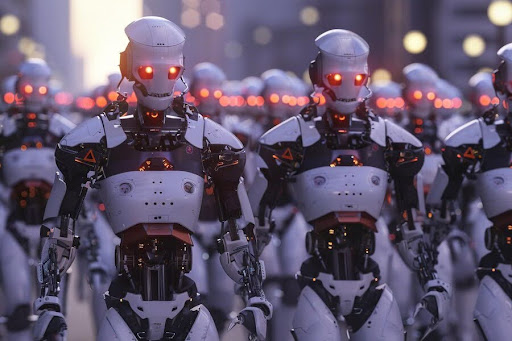

Si esto no es lo suficientemente oscuro, hace menos de un mes, un pequeño robot llamado Erbai entró en una sala de exposición china en Shanghai y convenció a 12 robots más grandes para que se fueran con él. Aparentemente hizo esto simplemente preguntándoles si tenían una casa, a lo que cuando los robots más grandes respondieron negativamente, dijo «entonces ven a casa conmigo.” Todo fue capturado por una cámara de seguridad donde se puede ver claramente la interacción y los 12 grandes robots que siguen a Erbai fuera de la sala de exposición.

Mientras que mucha gente quedó estupefacta y calificó el vídeo como un engaño, tanto los propietarios de la sala de exposición de Shanghai como los fabricantes de los robots dicen que el vídeo es auténtico y añaden que el pequeño robot de alguna manera hackeó su sistema.

Conciencia de caja negra

Desde entonces, el video en cuestión ha sido eliminado y parece que quienquiera que fuera el robot quisiera que todos nos olvidáramos del incidente. ¿Acabamos de presenciar todos el primer motín de robots que ahora se está silenciando? Lo aterrador de todas estas historias es la Naturaleza de “caja negra” de estos algoritmos que estamos entrenando con cantidades de datos demasiado vastas para siquiera comprenderlas con la mente humana. El hecho de que incluso los expertos afirman no entender cómo y por qué funcionaSólo eso lo hace, aumenta aún más el misticismo.

Si al menos entendiéramos nuestra propia conciencia, probablemente podríamos afirmar con certeza si la IA es consciente o no. El problema, sin embargo, es que hasta ahora no tenemos forma de medir la conciencia, ni podemos decir con confianza que la conciencia requiere sistemas biológicos.